1. 웹크롤링_청년신문

0) 현재 글

사랑이네 ㅇㅂㅇ :: '이직준비/웹크롤링' 카테고리의 글 목록 (tistory.com)

'이직준비/웹크롤링' 카테고리의 글 목록

checkit3625.tistory.com

* python 파일

1) 파이썬 pg 설치

사랑이네 ㅇㅂㅇ :: 머신러닝 1일차_0713 - (파이썬 복습: 아나콘다 설치/ 리스트, 딕셔너리/ 데이타 분석방법) (tistory.com)

2) 웹크롤링 참고링크

① 구글링 - 파이썬 크롤링 csv 저장

[크롤링] BeautifulSoup 으로 가져온 데이터 CSV(엑셀)파일로 저장하기 (tistory.com)

[크롤링] BeautifulSoup 으로 가져온 데이터 CSV(엑셀)파일로 저장하기

이번에는 네이버 금융 사이트에 있는 국내 증시 시가총액 순위 1위부터 200위까지 가져오는 실습을 해볼 생각입니다. 가져오는 것으로 끝나지 않고 csv 모듈을 사용해서 csv 엑셀 파일로 저장해보

domdom.tistory.com

3) 분석

① html 데이터 분석

② 한 페이지에 내가 원하는 컬럼별 데이터 출력 (+불필요한 태그 값 제거)

③ 페이징 단위로 출력

④ 데이터 csv 파일로 내리기

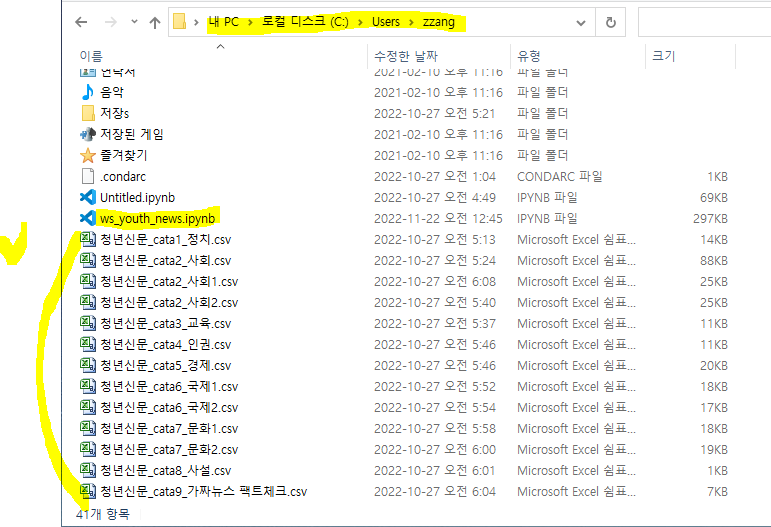

4) 결과물s

① GitHub Gist (o95959)

웹크롤링_청년신문

웹크롤링_청년신문. GitHub Gist: instantly share code, notes, and snippets.

gist.github.com

* GitHub Gist 사용법

https://brunch.co.kr/@mystoryg/146

GitHub Gist 사용법

브런치에서 사용하는 방법 | 브런치 에디터에서 드디어 GitHub Gist를 지원한다. 그동안 브런치에는 코드가 예쁘게 들어가지 않아서 IDE를 그대로 캡처도 해보고 Color Scripter도 사용해봤다. 불편했다

brunch.co.kr

② Jupyter nbviewer

Jupyter Notebook Viewer (nbviewer.org)

Jupyter Notebook Viewer

for page in range(1, 5): res = requests.get(url + str(page)) res.raise_for_status() soup = BeautifulSoup(res.text, 'lxml') data_rows = soup.find('div', attrs={'class':'whois-board-row'}) for row in data_rows: sbj_rows = row.find_all('div', attrs={'class':'

nbviewer.org

* NbViewer를 통해 Jupyter Notebook Share하기

https://3months.tistory.com/12

NbViewer를 통해 Jupyter Notebook Share하기

/**NbViewer를 통해 Jupyter Notebook Share하기작성자 : 3개월2016/11/7*/ Jupyter notebook으로 작성한 코드를 누군가와 공유하고 싶을 때Nbviewer를 사용하면 간편하게 웹을 통해 코드와 코드의 실행 결과를 공유

3months.tistory.com